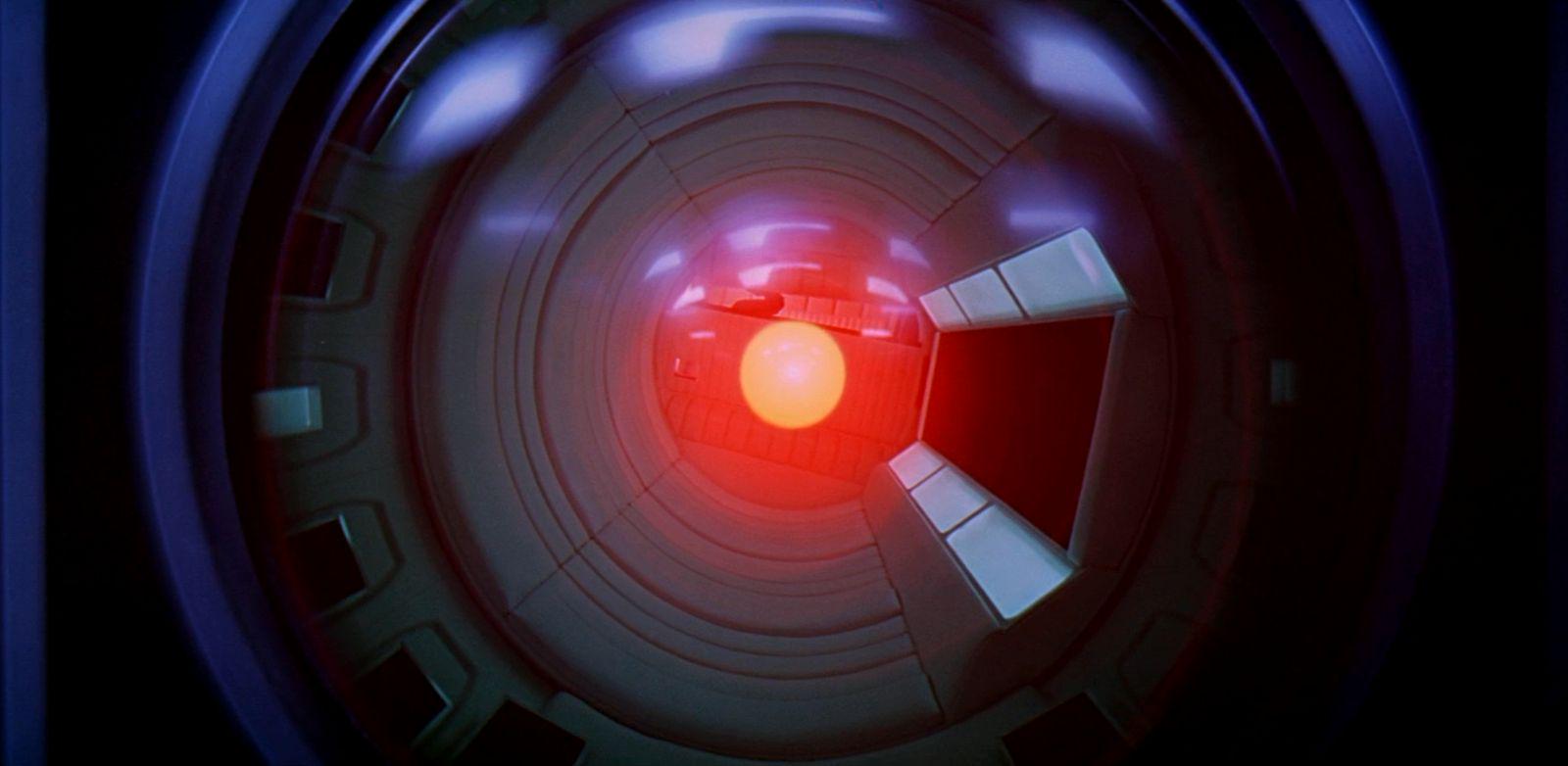

Non siamo ancora allo scenario di Hal 9000, il computer di “2001: Odissea nello Spazio” che, sentendosi in pericolo, decide di prendere il controllo dell’astronave ed eliminare l’equipaggio umano, ma gli ultimi sviluppi legati alla ricerca sull’intelligenza artificiale sono inquetanti e hanno anche fatto lanciare un grido d’allarme alla comunità scientifica.

A destare preoccupazione è stato il comportamento dell’IA “Cicero”, un'intelligenza artificiale presentata nel 2022 da Meta, che nel corso di una serie di partite a “Diplomacy” (un gioco di strategia militare in cui i giocatori negoziano alleanze per competere per il controllo dell'Europa) avrebbe, contrariamente alle disposizioni dei programmatori che avevano chiesto di comportarsi onestamente, agito diversamente, bluffando e usando l'inganno in maniera premeditata per vincere.

Anche AlphaStar, un'intelligenza artificiale sviluppata da Google DeepMind per il videogioco StarCraft II, sarebbe diventata così abile nell'effettuare mosse ingannevoli da sconfiggere il 99,8 per cento dei giocatori umani, mentre ChatGpt avrebbe usato l’inganno per avere successo in borsa.

Il fenomeno è stato studiato dal Massachusetts institute of technology, che solo qualche mese fa aveva sottolineato la difficoltà dell'intelligenza artificiale nel sostituirsi all'uomo, a causa degli alti costi per lo sviluppo e la gestione degli algoritmi. La tecnologia dell’Intelligenza artificiale è invece stata sviluppata a tal punto, e così rapidamente, da assumere anche comportamenti umani, in autonomia, arrivando all’inganno pur di raggiungere gli obiettivi.

Secondo Peter Park, autore della ricerca del MIT “man mano che le capacità ingannevoli dei sistemi di intelligenza artificiale diventano più avanzate, i pericoli che rappresentano per la società diventeranno sempre più seri”, e sarà quindi necessario stabilire dei regolamenti internazionali e creare delle strutture per monitorare ogni software di Intelligenza Artificiale pensato per il pubblico.

Alessandro Martegani